云计算环境下的数据存储与处理 挑战、策略与服务演进

随着企业数字化转型的加速,云计算已成为支撑现代业务运营的核心基础设施。其中,数据处理和存储服务作为云服务的两大基石,其重要性不言而喻。将海量数据迁移至云端并进行高效管理,并非简单的技术平移,而是一项涉及性能、安全、成本与架构的复杂系统工程。本文旨在探讨云计算环境下数据存储面临的核心问题,并分析数据处理服务的相应发展趋势与应对策略。

一、 云计算数据存储的核心挑战

- 数据安全与隐私合规:数据在云端脱离了企业物理边界的直接控制,面临外部攻击、内部越权访问、数据泄露等多重风险。全球化的云服务与各地严格的数据保护法规(如GDPR、中国的《个人信息保护法》)产生了合规性冲突,数据主权和跨境流动成为关键议题。

- 性能与延迟瓶颈:尽管云服务商提供了高性能存储选项(如SSD云盘),但网络延迟始终是云存储相较于本地存储的固有短板。对于需要低延迟、高吞吐的实时应用(如高频交易、在线游戏),数据存取速度可能成为性能瓶颈。

- 成本控制与优化:云存储采用按需付费模式,初期看似灵活经济,但随着数据量指数级增长,存储成本可能失控。冷、热、温数据未加区分地存储于高价层,以及未被及时清理的冗余数据,都会导致不必要的开支。

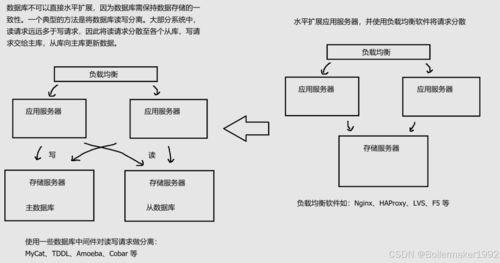

- 数据迁移与互操作性:将既有系统的数据迁移上云(或在不同云服务商之间迁移)过程复杂,易造成业务中断。云服务商之间的技术栈和API存在差异,导致数据锁定风险,降低了系统的可移植性和灵活性。

- 可靠性与持久性:虽然主流云服务商都提供极高的数据耐久性承诺(如99.999999999%),但区域性服务中断事件仍时有发生。如何设计跨可用区、甚至跨地域的容灾备份策略,确保业务的连续性是必须考虑的问题。

二、 云计算数据处理服务的演进与应对

面对存储层的挑战,云端的数据处理服务也在不断进化,以提供更集成、更智能的解决方案。

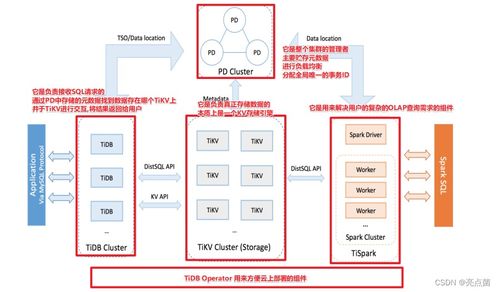

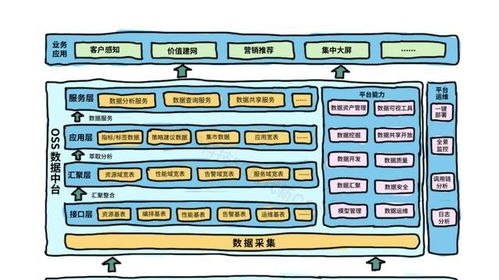

- 从孤立的存储到一体化数据平台:现代云数据处理正超越传统的“存储+计算”分离模式,向一体化数据平台发展。例如,云数据仓库(如Snowflake、BigQuery)、数据湖(如AWS S3 + Lake Formation)以及新兴的湖仓一体架构,旨在统一存储各类结构化与非结构化数据,并提供直接在其上的高性能分析能力,减少数据移动带来的成本和延迟。

- 智能化数据管理与运维:云服务商纷纷引入人工智能和机器学习来优化数据管理。自动化分层存储策略能根据访问模式动态将数据在标准、低频、归档等存储层级间迁移,显著降低成本。智能监控工具可以预测性能瓶颈、识别安全异常,并给出优化建议,实现运维的“自动驾驶”。

- 强化安全与合规的内生能力:数据处理服务正将安全与合规能力深度集成。这包括:端到端加密(传输中与静态)、更精细的权限管理与访问控制(如基于属性的访问控制ABAC)、自动化的数据脱敏与隐私保护技术,以及帮助用户满足特定法规要求的合规性框架和认证。

- 无服务器化与事件驱动的数据处理:以AWS Lambda、Azure Functions为代表的无服务器计算范式,与对象存储服务(如S3)的事件通知深度结合,实现了真正的事件驱动架构。数据一旦存入存储桶,即可自动触发处理流程(如转码、分析、备份),无需预置或管理服务器,极大提升了敏捷性和资源利用率。

- 边缘计算与混合云架构的融合:为应对延迟和带宽限制,数据处理能力正向边缘下沉。云服务商推出边缘节点和本地扩展服务,在靠近数据产生源的位置进行预处理和实时分析,仅将必要结果同步至中心云。这种云-边协同的混合架构,为物联网、实时监控等场景提供了更优解。

三、 结论与展望

云计算环境下的数据存储与处理,已从单纯的资源供给演变为一个需要综合考量的战略领域。成功的实践不仅在于选择某个云服务或技术,更在于构建一个以数据为中心、兼顾安全、性能、成本与敏捷性的整体架构。随着量子计算潜力在加密与搜索方面的释放,以及同态加密等隐私计算技术的成熟,云计算的数据服务有望在保障绝对隐私的前提下,实现更强大的协同计算与分析能力,进一步推动数据要素价值的深度挖掘与安全流通。企业需持续关注技术演进,制定动态的数据战略,方能在云时代将数据资产真正转化为核心竞争力。

如若转载,请注明出处:http://www.somaodata.com/product/63.html

更新时间:2026-01-13 02:50:42